Search Central Live Deep Dive 2025 現地レポート!

awooチームはタイ・バンコクで開催された、Google主催のアジア太平洋地域初となる「Search Central Live Deep Dive」に参加。

3日間にわたる技術カンファレンスには、世界各地の検索エキスパートや開発者が集結し、Google検索の裏側、AIとの融合、コンテンツ戦略、テクニカルSEOなど多岐にわたるテーマが議論されました。

このレポートでは、awooチームが現地で得た知見を日ごとにまとめてご紹介。初日となる本記事では、「AI検索時代における検索エンジンの原理とコンテンツ戦略の転換」に焦点を当てます。

コンテンツ

Search Central Liveとは?

Search Central Liveは、GoogleのSearch Centralチームが主催する公式イベントで、ウェブサイト運営者、開発者、SEO専門家向けに開催されています。

今回開催された「Search Central Live Deep Dive」は、そのアドバンス版とも言える3日間の集中カンファレンスです。内容もより高度で、検索の根本的な仕組みや最新技術に踏み込んだ議論が展開されました。

このイベントの最大の魅力は、従来の短時間型から、3日間にわたる本格的な学習プログラムへと大きくスケールアップしている点です。以下に、主な注目ポイントをご紹介します。

- Google公式チームとコミュニティの専門家による深掘りセッション

- 実際の成功事例の共有と、技術的なワークショップ

- Search ConsoleやGoogle Trendsといったツールの実践的な活用法解説

- 参加者同士の活発な質疑応答や、国境を越えたネットワーキング

このイベントは、世界のSEO最前線と知見を同期させる、またとない貴重な機会です。私たちがイベントで得た現地の情報とセッションの要点を整理してお届けします。

Day1のサマリ:AI検索とSEOの未来像

- SEOの時代は終わらない。だが、変革の時。 今後はランキングよりも存在感が重要に

- AI検索によって見た目は変わっても、検索の基本的なプロセスは変わっていない

- 特別なGEO対策は不要。SEOの基礎を徹底することが、これまで以上に重要

- Search Console、robots.txt、クロールバジェットといったテクニカルな要素が、引き続き競争力の鍵となる

【時系列レポート】Day1全セッションのハイライト

オープニングセッション:AIは検索をどう変えたのか?(11:00–11:35)

初日の幕開けは、参加者全員が盛り上がるインタラクティブなゲームから。司会者が参加者にSEOの経験年数を尋ねると、なんと20年以上のキャリアを持つプロフェッショナルが3〜5名も名乗り出る展開に。会場がどよめきました。

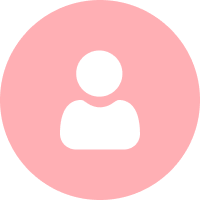

そして、Googleチームは冒頭から核心に触れました。

「検索とは、永遠に“解決できない課題”です。だからこそ、私たちは進化し続けなければなりません。」

Google検索は、ショッピング機能や「この検索結果について」などの機能を通じて進化してきましたが、現在はAIO(AI Overviews)の登場により、自然言語・画像・音声・対話型の入力を統合し、よりユーザーの日常的な行動に即した検索体験が実現されています。AIはもはや検索の“補助”ではなく、“中核”に位置づけられていると強調されました。

実際、Googleの公式データもそれを裏付けています。18〜24歳の若年層ユーザーはAIOへの満足度が非常に高く、複雑な質問も一度に解決できる点が評価されています。特に、ロングテールクエリの成長は、ショートクエリの約1.5倍という結果も出ています。

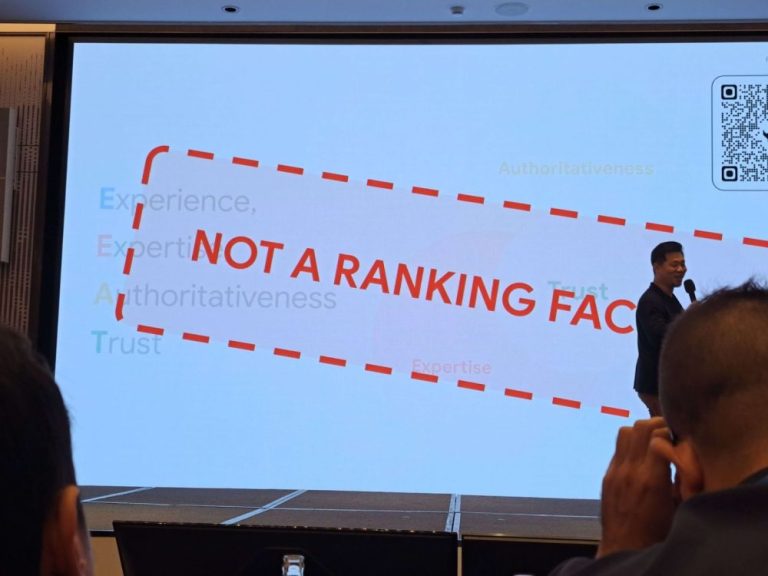

では、SEO担当者は「GEO」や「AEO(AI Engine Optimization)」に取り組むべきなのでしょうか? GoogleのGary Illyes氏の答えは明確でした。

「基本に忠実に、SEOをしっかり続けてください。」

彼は、GoogleのAI検索も、従来と同じ技術基盤で動いており、本質的な評価軸は変わっていないと強調。「AIが書いたか、人間が書いたか」は問題ではなく、コンテンツの品質がしっかりしていれば、それだけで十分評価対象になるというのがGoogleのスタンスです。

AI時代も検索エンジンの仕組みは同じ(11:45)

「AIの進化によって、SEOの役割は終わったのか?」会場では再び、そんな疑問が投げかけられました。

GoogleのGary Illyes氏は、笑いを交えつつこう語ります。「1997年から“SEOは死んだ”と言われ続けてますが、今もちゃんと生きていますよ。」

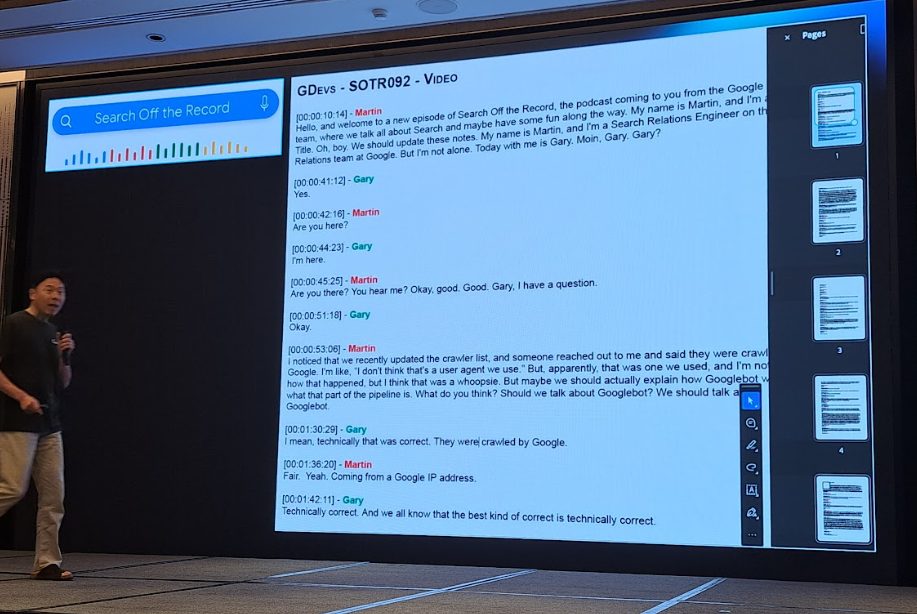

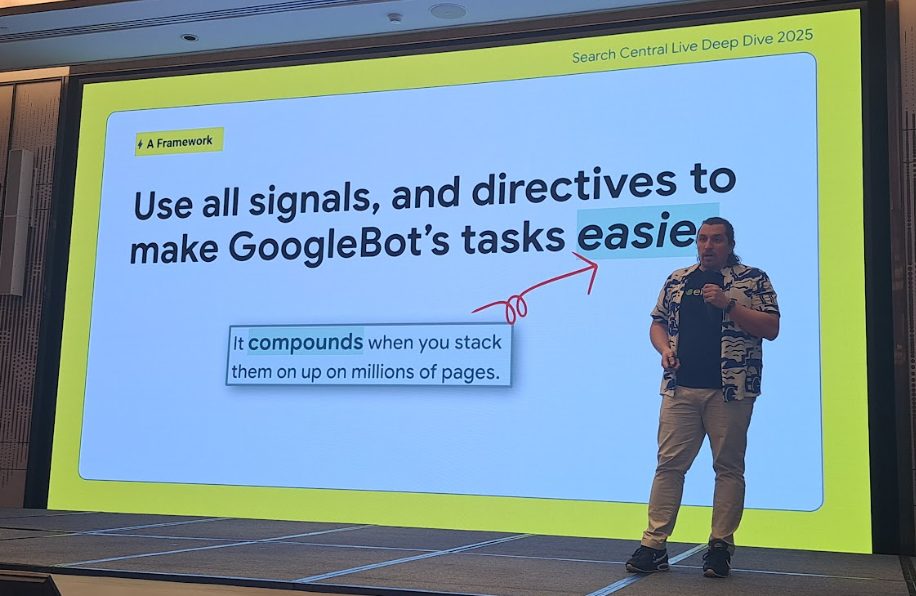

AIO、AI Mode、Geminiといった新技術が登場しても、検索の根幹をなすプロセスは変わらない、と彼は断言します。

- Googlebotによるクロールは継続される

- インデックスされるべきコンテンツは、これまで通りインデックスされる

- ランキングはRankBrainやMUMなどのアルゴリズムで判断

「私たちはAIの生成したコンテンツと人間が書いたコンテンツの違いを見分けようと試みていますが、正直なところ、コンテンツの品質が高ければ、誰が書いたかは問題ではありません。」

GEOやAEOといった新しい手法に、必ずしも飛びつく必要はありません。SEOの基本をしっかり押さえ、質の高いコンテンツと正しい技術設計があれば、AI検索でもきちんと評価されます。

⚡ライトニングトーク①:AI、コンテンツ、SEOの新たな協力体制(13:05)

このライトニングトークでは、戦略からツール活用まで、各分野の専門家が具体的なアプローチを共有しました。

1. 部門の壁を越え、AI検索に最適化されたコンテンツへ

AI時代の検索に対応するには、コンテンツチームが部門の垣根を越えて協力する必要があります。登壇者によれば、個人の体験や独自の視点を盛り込んだコンテンツこそが、AIに“見つけられる”鍵となるため、組織を横断した協業が不可欠だといいます。

登壇者:The Egg / 企業ページ:The Egg | Digital Marketing Agency

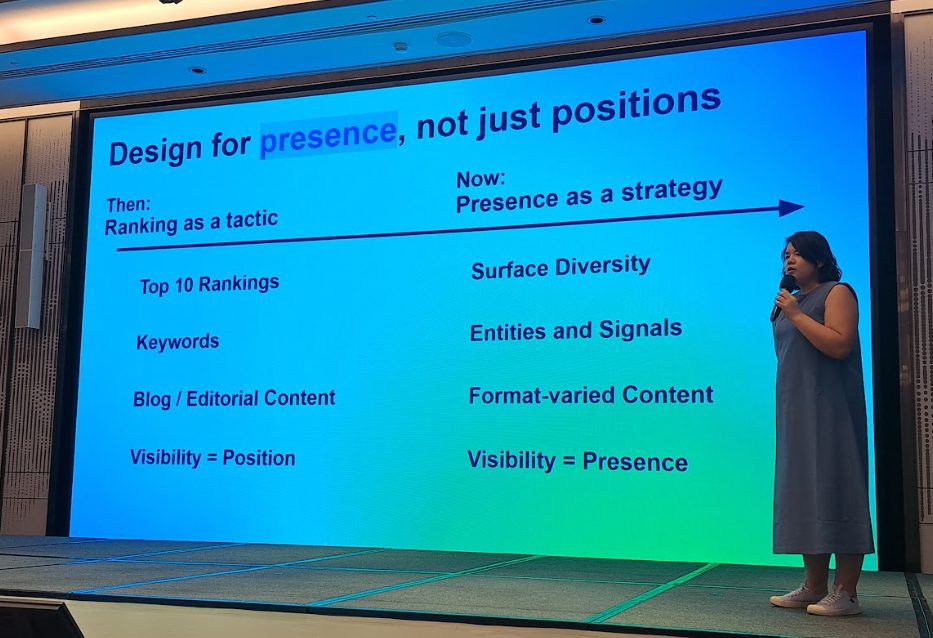

2.AIO時代の勝ち筋は「順位」よりも「存在感」

AI検索では「1位を取る」ことよりも、どれだけ多くの場所に自社コンテンツが現れるか=存在感が重視されます。存在感を高めるには、エンティティの最適化、画像・動画といったマルチメディアの強化、そしてSNS上での言及が鍵となります。

登壇者:MengJung Tsai

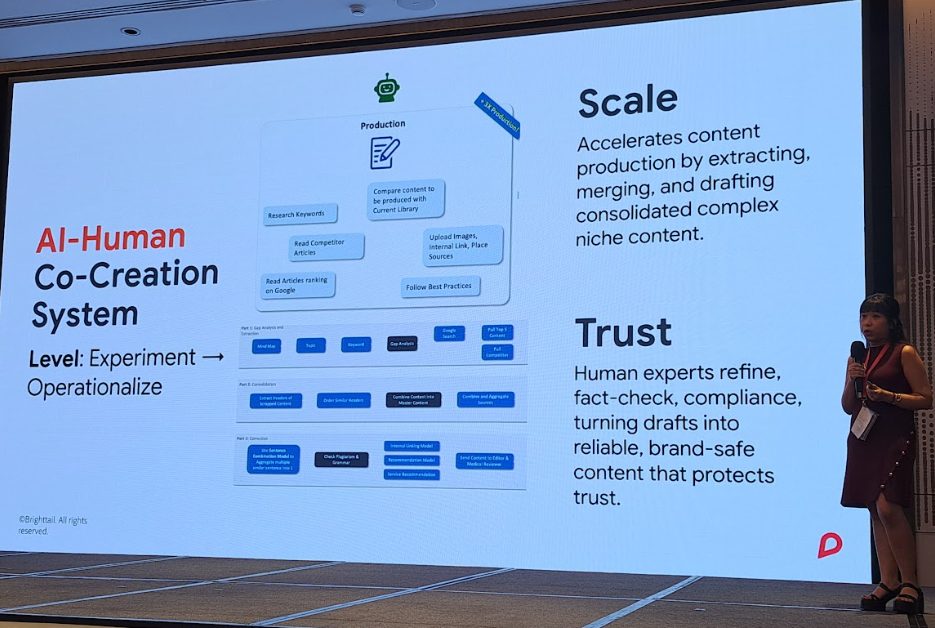

3.AI × 編集チームによるハイブリッド型コンテンツ戦略

登壇者が紹介したのは、AIを起点としたコンテンツ制作プロセス。

まずAIを活用してユーザー課題を分析し、トピッククラスターを構築。その後、AIによって初稿を生成し、最終的には編集チームが文章を磨き、ストーリー性を加えます。スピードとクオリティを両立するこの制作スタイルが、すでに新たなスタンダードになりつつあります。

登壇者:Ayu Idris

4.“Product-led SEO”という新潮流:SEOは開発と戦略の中核へ

従来の「ページ単位での最適化」にとどまらず、SEOをプロダクト構造そのものに組み込む。それがProduct-led SEOの本質です。

講演では、求人プラットフォーム「Glints」の事例が紹介されました。

彼らはマーケ部門ではなくプロダクト部門と連携し、コンテンツギャップを分析。突いた10万ものカテゴリーページを生成。そこから10万ページ以上のカテゴリ構成を設計し、検索流入を2倍以上に成長させることに成功しました。

登壇者:DailySEO ID

5.「AIで書いたらSEOでペナルティとなる?」

「AIでコンテンツを書いたら検索評価が下がるのでは?」という懸念に対し、「重要なのは“誰が書いたか”ではなく、“どう使ったか”です。」と、登壇者は断言します。

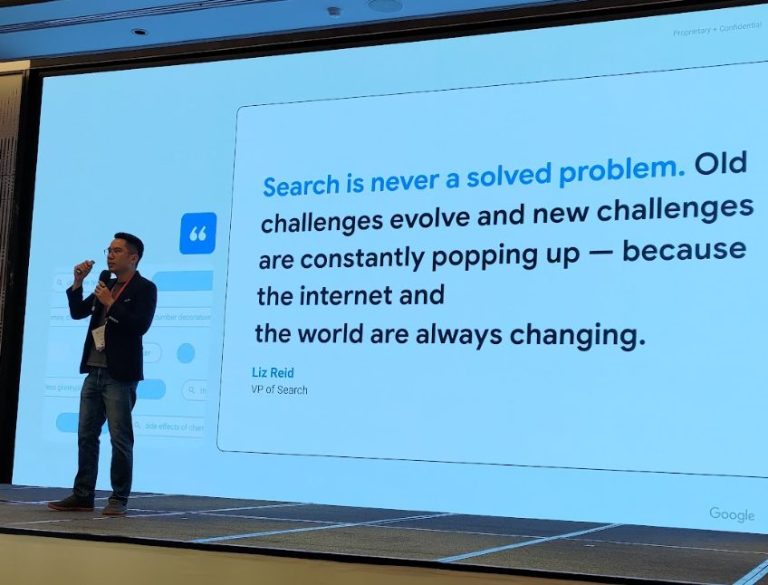

AIにテーマ選定やキーワード抽出、初稿作成を任せるのはまったく問題ありません。ただし、最終的には自社の視点や一次情報、リアルな体験を加えることが、E-E-A-T(経験・専門性・権威性・信頼性)を満たすために不可欠だと強調しました。

登壇者:Maya Journals

6.コンテンツは“情報の羅列”ではなく、“ストーリー”であるべき

講演者によれば、GSCの実データからはケーススタディや競合比較など、実践的な体験を語るコンテンツの方がSEO効果が高い傾向が明らかになっているとのこと。とりわけE-E-A-Tの中核をなす「Experience(経験)」は、単なる専門用語や事実よりもはるかに強く評価される要素であり、“語れる経験”こそがSEOにおける信頼の源泉であると話します。

登壇者: Nitesh S.

7.Gemini × NotebookLM × Google Studio──生成AIを使ったコンテンツ戦略の組み立て方

このセッションでは、Gemini、NotebookLM、Google Studioを連携させて、コンテンツ戦略を構築する実践的なワークフローが紹介されました。

特に印象的だったのは、“AIにプロンプトエンジニアの役割を与えて、プロンプトそのものを改善させる”というTips。ちょっとした工夫で、AI活用の精度が大きく変わることが実感できるセッションでした。

午前中はAI検索に対応するための思考と戦略のアップデートに焦点が当てられた一方、午後はそれを支えるテクニカルSEOのコア領域に深く踏み込む内容でした。Search Consoleの活用法からクロールバジェット(検出予算)の最適化まで、一見すると地味な“エンジニアリングの領域”が、SEO成果を左右する本質的な競争力であることが改めて示されました。

Search Consoleを使いこなし、サイトのポテンシャルを最大化する(14:00)

多くの人が「エラー通知ツール」と捉えがちなGSCですが、実際にはクロール、インデックス、検索クエリ分析、そしてランキング表示という、検索の全プロセスを可視化するツールです。

特に注目の機能:

- ✅ Recommendation Cards:改善すべきページやインデックスされていないURLを自動抽出し、具体的なアクションを提案。

- ✅ 「24時間以内」のデータ表示:データの反映が遅いというユーザーの声に応え、よりリアルタイムに近いデータ表示が可能になり、イベント時などの即時分析に便利。

ちなみに、Google Search Consoleのロゴが新しくなったことにも触れられました。

クロールの仕組み:単なるBot巡回ではない、その舞台裏(14:30~14:55)

このテクニカルセッションは、「検索とは、単にGooglebotがウェブを巡回しているだけではなく、その裏には極めて緻密なロジックが存在する」ことを再認識させてくれるものでした。

以下は、その検索プロセスの全体像です。

- 基盤プロトコル:TCP/IP、URL、DNS、HTTPリクエストといった基本的なネットワーク知識が前提となる。

- クロールキュー(待機列)のロジック:サイトマップ、RSS、過去のクロール履歴、GSCからの送信リクエストなどを考慮し、優先順位を付けてクロール順が最適化されている。

- robots.txtのルール遵守:データ取得前には、必ず対象ページのクロールが許可されているかを確認する。

Googlebotがクロール対象を決める際、参照するのはサイトマップだけではありません。

過去にクロールしたページ、RSSフィード、サイト内リンク(内部リンク)や他サイトからのリンク(外部リンク)など、複数の経路から情報を取得しています。

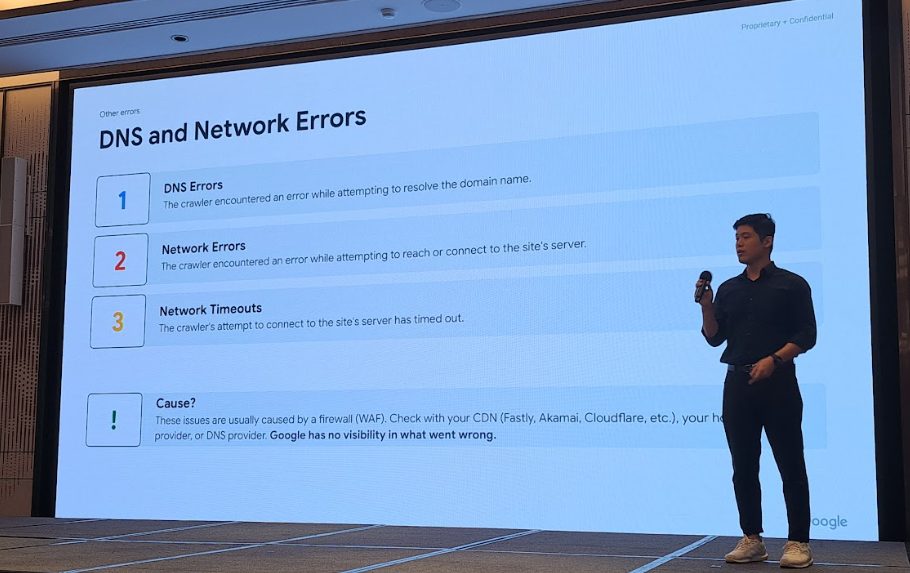

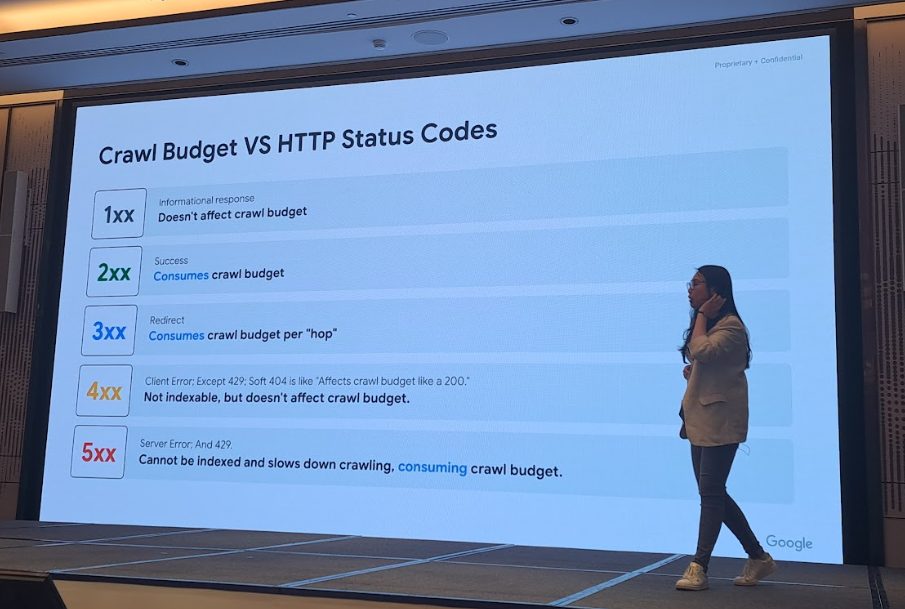

「クロールが失敗する場合の対策」もSEOの重要な論点として挙げられました。以下のようなケースは、貴重なクロール予算の無駄遣いや、インデックスの非効率化につながります。

- Soft 404(ステータスコードは200だが、実質的には存在しないページ): 正常なページと誤認され、貴重なクロールリソースを無駄に消費します

- 3xx リダイレクト:回数が多いほど、ボットのリソースを浪費します

- 5xx サーバーエラー:インデックスを妨げ、クロール効率を著しく低下させます

- DNSエラー、ネットワークタイムアウト:これらの問題はGSCでは検知できないため、CDN(Cloudflareなど)やDNSプロバイダーのログで確認する必要がある

要するに、検索システムは非常にデリケートです。エラーページを放置して、貴重な露出機会を無駄にしないようにしましょう。

参考資料:HTTP ステータス コード、ネットワーク エラーおよび DNS エラーが Google 検索に及ぼす影響

Googleはrobots.txtをどう解釈しているのか?(15:25)

「robots.txtはで錠前ではなく、あなたのサイトの“玄関”。」

セッションでは、このファイルの役割と重要性について、改めて基本に立ち返る解説がなされました。

「1994年、robots.txtを使っていたサイトはわずか12でした。しかし今や、これはウェブの至る所に存在する基本的な仕組みです。」

そして、AI検索時代における新たな注意点として、以下が挙げられました。

- robots.txtは誰でも閲覧可能な公開ファイル。 絶対に機密情報は書かないこと

- AIクローラーもrobots.txtを参照するため、記述はより正確に行う

BardやVertex AIといったGoogleの生成AIによるサイトコンテンツの利用をブロックしたい場合は、以下のように記述します。

user-agent: google-extended

Disallow: /

参考資料:Google による robots.txt の指定の解釈

Googleが語る「クロールバジェット」の考え方(15:55)

多くの人が誤解しがちな、しかしサイト運営に大きな影響を与える「クロールバジェット」についての解説です。

「簡単に言えば、Googlebotがあなたのサイトに対して、1回にクロールしてくれるページ数の上限を表す指標です。」

クロールバジェットは、以下の要因によって決定されます。

- サイト全体の品質

- ページの更新頻度

- サーバーの応答速度

特に、以下のケースはバジェットを著しく浪費するため注意が必要です。

❌ 無限に生成される動的URL(絞り込みや並び替えパラメータなど)

❌ 重複コンテンツ、価値の低いページ

❌ エラーを返すページ(特に5xx系エラーやSoft 404など)

小規模なサイトではあまり気にする必要はありませんが、中〜大規模サイト、メディア、ECプラットフォームでは必須の管理項目です。GSCとサーバーログの監視を組み合わせることが、最適な対策となります。

会場から「AI Mode(AIO)はクロール量を増やしますか?」という質問が出ました。

Gary氏の答えは「その可能性はある」とのこと。AI検索はより多くの文脈や関連情報を必要とするため、Googlebotの活動がわずかに増加する可能性がある、と述べました。

⚡ライトニングトーク②:大規模サイトにおけるクロール管理実践例(16:15)

このセッションでは、大規模サイトの運営をテーマに、3つの具体的な成功事例が共有されました。

1️⃣ 事例1:1億ページ超の巨大サイトをどう最適化するか?

- 価値のないタグページはすべてnoindex指定

- API関連のエンドポイントは、robots.txtでクロールをブロック

- 重要度の低いページへの内部リンク数を減らし、クロールリソースの分散を防ぐ。

登壇者:Gaston Riera – SEO Specialist

2️⃣ 事例2:インド航空では、10万ページを生成しても成果ゼロ。その原因は「内部リンク構造」

インド航空は、6つのテンプレートと16の国別展開を掛け合わせ、一気に約10万ページを公開。しかし、非指名検索での流入はほぼゼロ。大量に生成したページが、適切にインデックスも評価もされていない状態でした。

分析の結果、問題はコンテンツの質ではなくサイト構造にあると判明。内部リンクが少なく、ページ同士の関連性がGoogleに伝わっていなかったのです。

- 解決策:「近隣都市」ページへの相互リンクや、季節ごとの季節ごとの航路に合わせたページを設計し、横断的な内部リンクを追加

- 成果:セッション数は +846% 増加し、孤立ページ(オーファンページ)は 97% 減少

登壇者:Lakshey Bahl

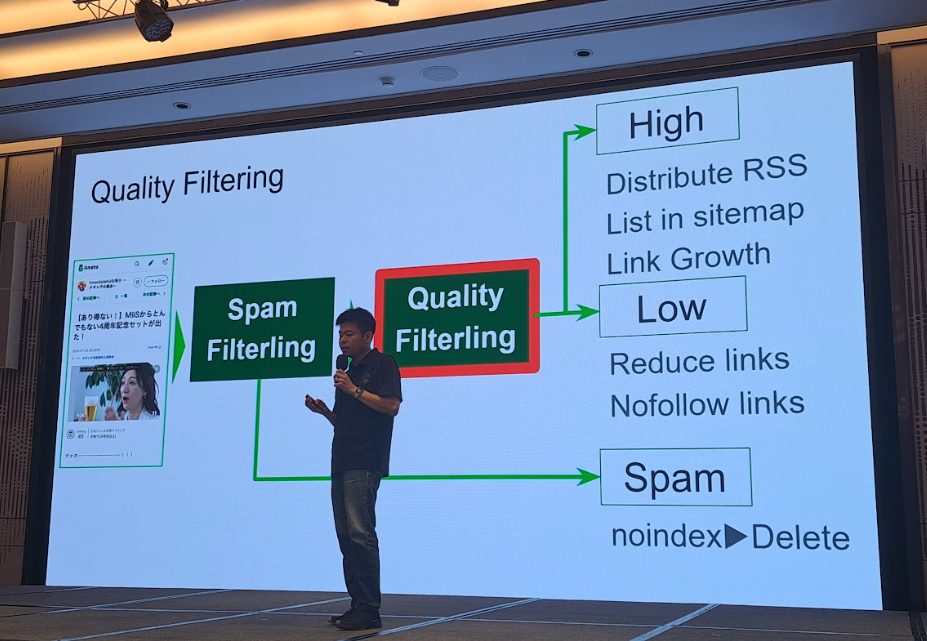

3️⃣ 事例3:機械学習で“低品質コンテンツ”を自動フィルタリング(Satoshi Kimura)

Satoshi Kimura 氏の発表は、「コンテンツの品質管理とリスク管理」に焦点を当てたものでした。彼の管理するサイトには、以下のような低品質コンテンツが大量に存在していました。

- アフィリエイト目的のスパムページ

- キーワードだけを詰め込んだドアウェイページ

- 外部リンクを大量に埋め込んだ価値のない誘導ページ

これらのコンテンツは、検索パフォーマンスに貢献しないばかりか、サイト全体のインデックス効率を悪化させます。

Kimura 氏のチームは、GSCと社内データを統合した「機械学習による品質フィルタリング(ML Quality Filtering)」の仕組みを構築しました。

- スパムフィルタリング:明らかなスパムを判定し、noindex または削除

- 品質フィルタリング:機械学習モデルでページの品質をスコア化し判定

- 分類後の処理::高品質コンテンツはサイトマップ・RSSに登録し、内部リンクを設定。低品質コンテンツはクロール対象から除外

フィルタリングの指標には、文字数、画像数、キーワードの出現頻度(TF-IDF分析)などが用いられました。

- 成果:高品質ページのインデックス率は 96% に向上し、サイト全体のトラフィックは 30% 増加。

登壇者:Satoshi Kimura

❓Q&Aセッション:現場の疑問にGoogle担当者が回答!

密度の濃い1日の締めくくりは、Q&Aセッションです。特に記憶に残った質疑応答をまとめました。

Q1|GSCでAIO(AI Overview)の表示回数などのデータは確認できるようになりますか?従来の検索と区別されますか?

A:現時点では技術的なアーキテクチャが異なるため、提供できません。

(登壇者が最後に投げた「Maybe…」という含みのある言葉に、会場には少し微妙な空気が流れました。)

Q2|AIOの満足度が高いというデータは、どのように測定しているのですか?

A:検証済みです!ただ、この場でデータをAirDropするわけにはいかないので(笑)。

Q3|llms.txtはGeminiのクロールや順位に影響しますか?

A:推奨しませんし、使う必要もありません。

AIは“理解する”ための存在であって、“ルールを守る”存在ではない」ため、Googlebotのようなクロール制御とは異なるロジックで動いているとのことです。

Q4|AI検索でクリック数が減るなら、SEOはもう意味がないのでは?エンゲージメントをどう測ればいいですか?

A:重要性は変わりません。ただ、測定方法が変わります。

今後は従来のクリック数や順位だけでなく、「ブランドが画像、動画、ナレッジパネルなど、どれだけ多くの検索結果フォーマットに表示されたか」が重要になります。ライトニングトークで語られた 存在感 > ランキング順位 の考え方が、ここでも改めて強調されました。

Q5|サイトマップを送信しているのに、GSCで「サイトマップに参照されていないURL」とレポートされるのはなぜですか?

A:Googlebotが、サイトマップを見るより先に他の経路でそのURLを発見した可能性が高いです。

エラーではなく、単に検出ルートが異なるだけとのこと。心配する必要はありません。

Q6|GoogleはAIが書いたコンテンツと人が書いたものを区別しないのですか?

A:区別しようと試みてはいますが、実質的に意味がないと考えています。

画像とは違い、テキストは“誰が書いたか”を見分けるのが非常に難しい。Googleが最も重視するのは「コンテンツの品質」であり、「作成者」ではありません。

Q7|サイトのステータスコード2xx(成功)の割合は、90%以上であるべき、といった基準はありますか?

A:そのような明確な基準は設けていません。

Q8|robots.txtで中国語(または日本語)URLをそのまま書いても大丈夫?

A:問題ありません。 URLをそのまま記述して大丈夫です。

Q9|ステータスコードは200 OKなのに、GSCでクロールやインデックスの問題が報告されることがあります。

A:レポートデータのタイムラグが原因である可能性があります。タイムスタンプを確認して比較することをおすすめします。

Q10|将来的にAIクローラー専用のクロール指示がrobots.txtに追加される可能性はありますか?

A:議論はされています。 将来的にrobots.txtにAI専用の構文が追加されるかもしれません。

Q11|AI Modeはいつ正式リリースされますか?

A:それを話したらクビになります(笑)

awooの考察

Day1のセッション全体を通して見えてきたのは、AI検索はSEOを「終わらせるもの」ではなく、むしろ私たちを「SEOの本質」へと立ち返らせるものだということです。

Gary氏が繰り返した「GEOのような特別な対策をしなくても、良いSEO対策を続ければいい」というメッセージや、各登壇者が強調した「存在感」の概念、そして「Product-led SEO」といった先進事例は、私たちの確信を強めるものでした。

結局、検索がどう変わっても、人にとって価値のある情報を、正しい構造と技術で届けることこそが、長期的な成功への唯一の道筋なのです。

まとめ

3日間にわたって開催された「Search Central Live Deep Dive」は、情報の密度だけでなく、世界中の検索の第一人者たちとリアルに議論・交流できる貴重な場でした。

awooは今後も、AI時代の検索トレンドを継続的にウォッチしながら、企業をサポートしてまいります。

次回のレポートでは、Day2の内容をお届けします。

テーマは「インデックス構造の解析と高度化」「非テキストコンテンツのSEO」「越境ECにおける国際対応」。どうぞご期待ください。

🔺現場の名物シーン

登壇者の時間がオーバーしそうになると、Gary氏が手にしたのは…なんと「叫ぶチキン」!

「ギャーッ!」という音で会場中がざわつき、笑いながらもスムーズに進行。まさに“Googleらしい”ユーモアで印象的な場面でした。

▎関連記事:專業 SEO 公司如何挑選?4大挑選原則讓你一次搞懂(台湾ブログ)

▎関連記事:【2025最新版】SEO是什麼? SEO怎麼做? SEO搜尋引擎排名優化一次搞懂(台湾ブログ)