Search Central Live Deep Dive 2025 現場直擊!

awoo 團隊現身泰國曼谷,參加亞太地區首度舉辦的 Search Central Live Deep Dive!這場為期三天的技術研討會,匯聚來自各地的搜尋專家與開發者,共同深入探索 Google 搜尋引擎的底層運作、AI 結合搜尋的最新應用、內容策略與技術 SEO 等重要議題。

本系列文章將依照每日主題,整理 awoo 第一手觀察與重點筆記。

今天是第 1 天,主題聚焦在:AI 搜尋模式下的搜尋原理與內容策略轉型

Search Central Live 是什麼?

Search Central Live 是 Google 搜尋中心團隊主辦的實體活動,專為網站經營者、開發人員與 SEO 專家設計。而 Search Central Live Deep Dive 則是「升級版」的三天進階研討會,內容更廣、時間更長,專為想深入理解搜尋背後機制的與會者而設。

這場活動最大的特色,就是從原本的半天或幾小時,延伸為三天完整學習行程,活動的亮點包含:

- Google 官方團隊與社群專家的深度演講

- 真實案例分享 × 技術實作工作坊

- Search Console、Google Trends 等工具的應用教學

- 豐富的現場互動與跨國交流機會

對於關注搜尋技術與自然流量成長的 awoo 團隊來說,這是與全球 SEO 最前線同步的寶貴機會!

awoo 實際參與本次活動,以下為我們從現場帶回的第一手觀察與筆記整理。

Search Central Live Deep Dive 第 1 天主題摘要

- SEO 沒死,但正在轉型!Presence(存在感)比排名更重要

- AI 搜尋雖然樣貌改變,但底層搜尋流程依然沒變

- 只需要把 SEO 基礎做好,不需要做 GEO

- GSC、robots.txt、Crawl Budget 等技術操作仍是關鍵競爭力

今日主題與逐場精華筆記(依時間軸整理)

開場互動 + 開幕主題演講(11:00–11:35)

活動從一個互動遊戲開始,主持人詢問大家做 SEO 的年資,現場有超過 3~5 位資深從業者已經投入超過 20 年。

接著 Google 搜尋團隊直接開門見山:

「搜尋是一個永遠無法被解決的問題,我們需要不斷演進。」

產品從 Shopping、About this result 到現在的 AIO,Google 搜尋持續整合自然語言、圖片、語音與對話式輸入,讓搜尋更貼近使用者日常行為。AI 已成為搜尋的核心,而非附屬。

官方 AIO 的數據也證明了這一點:18 ~ 24 歲用戶對 AIO 的滿意度極高,複雜查詢能一口氣解決,像是長尾查詢成長比短查詢快了 1.5 倍,複雜問題也能一口氣解決。

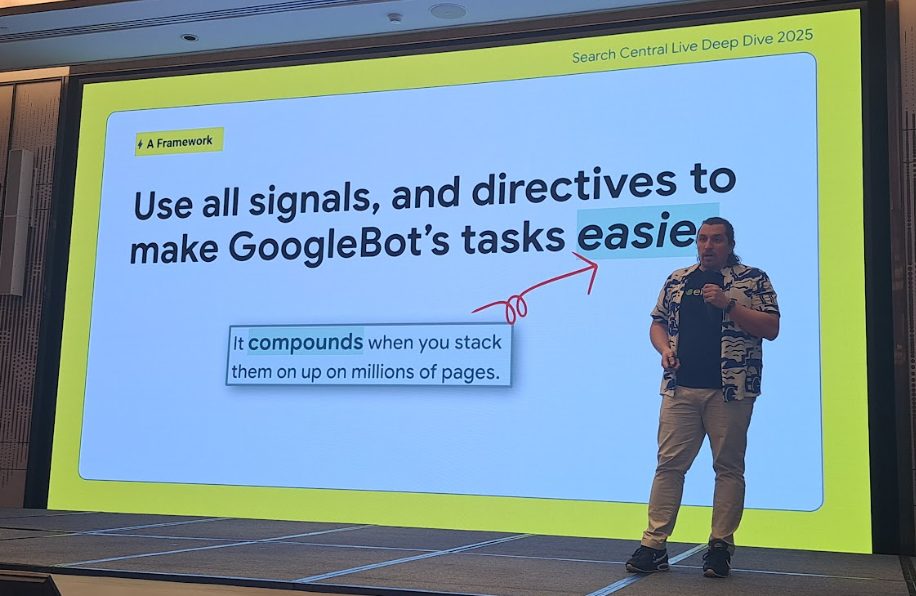

那 SEO 要變成 GEO、AEO 嗎?Gary Illyes 的回應很明確:

「不需要,你只要繼續做好 SEO 就對了。」

他強調,Google AI 搜尋系統用的還是同一套技術架構,只要內容品質到位,無論是不是 AI 寫的,Google 都接受。

搜尋引擎如何運作與人工智慧的角色(11:45)

AI 來了,SEO 還有位置嗎?「SEO 還活著嗎?」這問題在現場再次浮現。

Gary Illyes 一貫幽默地說:「從 1997 年就有人說 SEO 要死了,結果現在還活得好好的。」

即使出現 AIO、AI Mode、Gemini 等新技術,但底層搜尋流程沒變:

- Googlebot 還是照樣爬;

- 該索引的內容還是會被收錄;

- 排名依然依賴 RankBrain、MUM 等演算法。

「我們正在嘗試分辨 AI 內容與人寫內容的差異,但只要內容品質好,不管誰寫的都沒關係。」

不需要另外做什麼 GEO/AEO,只要把 SEO 的基本功做好,內容紮實、技術正確,AI 系統自然會把你選進去。

⚡Lightning Session A:AI、內容與 SEO 的協作進化(13:05)

這場閃電講 ( Lightning Session ) 從策略到工具通通有,幾位講者從不同角度提出具體做法:

- 打破企業團隊隔閡,讓內容更貼近 AI 搜尋邏輯

講者們認為,要因應 AI Search,內容團隊必須跨部門合作。內容要更聚焦個人經驗、特色觀點,這些因素會直接影響 AI 給你的「曝光機會」。

講者連結:The Egg / 網站連結:The Egg | Digital Marketing Agency

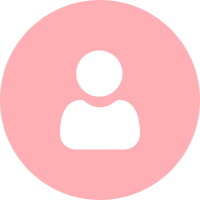

- AIO 強調的不是誰排第一,「存在感」才是目標

AI 搜尋不是拼誰排第一,而是誰能「出現在更多地方」。新的 SEO KPI 是 presence(存在感)> position(排名)。想要提升 presence,就要優化實體(Entity)、強化圖片、影音、多媒體素材,並結合社群訊號。

講者連結:MengJung Tsai

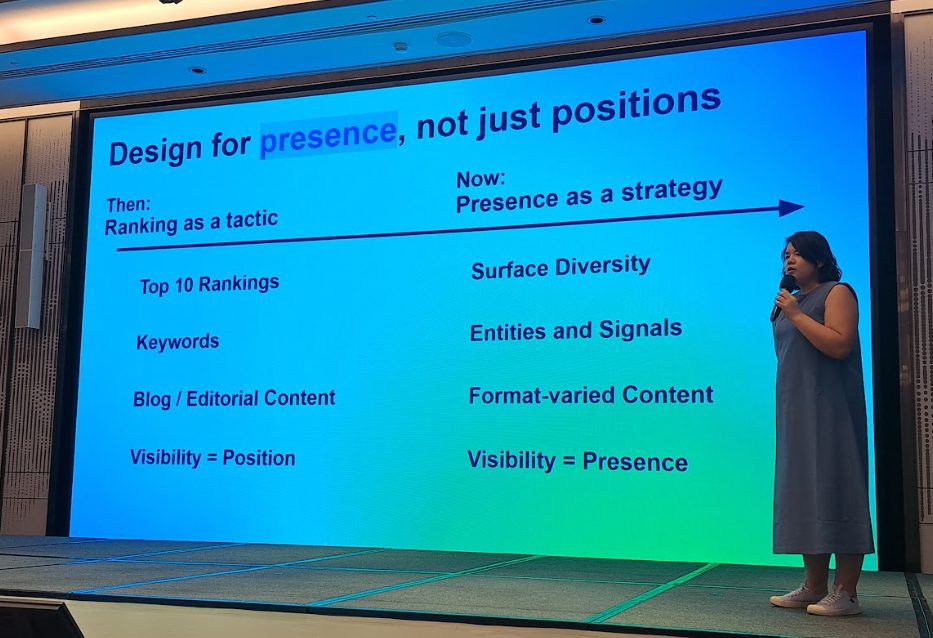

- 用 AI 建立內容藍圖,再由人修飾細節

講者分享他們的內容流程已經全面導入 AI:先用 AI 分析使用者問題、建立主題地圖(Topic Cluster),產出初稿,再交給編輯團隊潤飾、強化敘事,達到兼顧速度與品質的平衡,這種內容協作模式已成新常態。

講者連結:Ayu Idris

- Product-led SEO,SEO 不再只是行銷寫手,而是產品策略夥伴

SEO 是產品的一部分,而非單一網頁優化,以 Glints 為例,他們與產品部門合作,根據競品內容缺口,打造出 10 萬個分類頁,成功讓搜尋流量翻倍成長。

講者連結:DailySEO ID

- AI 寫內容到底會不會被懲罰?

講者說得很實在:「重點不是 AI 寫不寫,而是你怎麼用。」用 AI 協助選題、找關鍵字、產初稿都 OK,但別忘了,加入品牌觀點與第一手經驗才是 E-E-A-T 最重要的部分。

講者連結:Maya Journals

- 內容不是資料堆疊,而是要說故事

根據講者觀察 GSC 數據顯示,有成功案例、競品比較的內容,表現普遍更好。E-E-A-T 的核心就是 Experience,比什麼技術詞都還重要。

講者連結: Nitesh S.

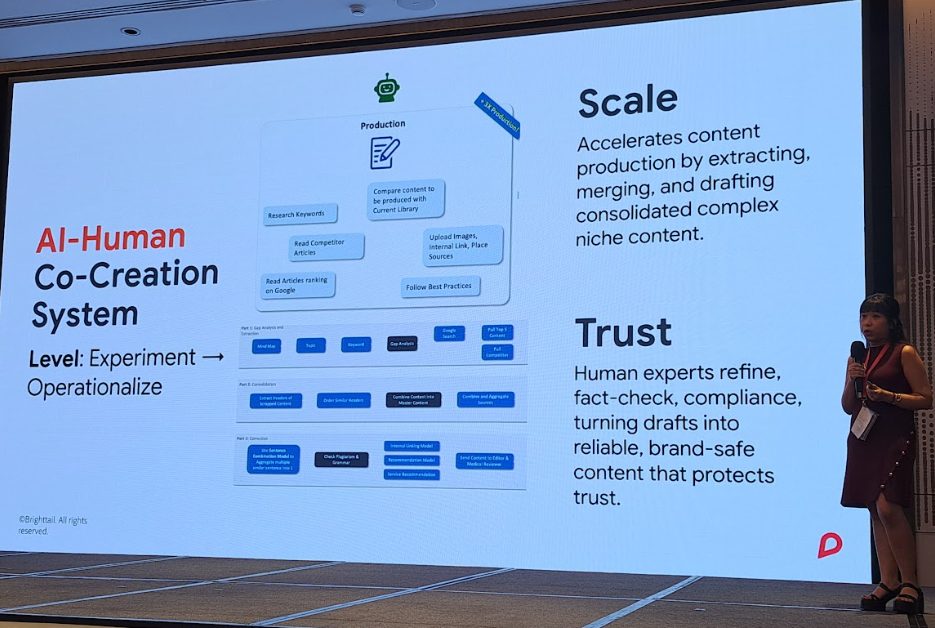

- 工具怎麼整合?Gemini + NotebookLM + Studio

一場實作型分享教大家怎麼用 Gemini、Notebook LM、Google Studio 打造內容策略流程,💡小技巧分享:讓 AI 「扮演 prompt 工程師」來幫你優化 prompt。

講者連結:鈴木謙一 SuzukiKenichi

上午場次聚焦在 AI 搜尋帶來的策略思維轉變,下午則深入探討了驅動這一切的底層技術,從 Search Console 的應用到檢索預算的分配,這些看似「工程化」的細節,依然是決定 SEO 成效的核心競爭力。

利用 Search Console 釋放您的網站潛力(14:00)

不同於大家印象中的「錯誤提示工具」,GSC 其實完整呈現了搜尋的技術流程:從檢索(Googlebot)、索引、查詢分析,到最後的排名呈現。

本場亮點功能包括:

- ✅ Recommendation Cards:自動分析網站狀況並給出建議行動(像是告訴你哪頁該優化、哪頁沒被收錄)

- ✅ 全新「24 小時內檢視」功能:因應使用者反映數據延遲問題,Google 嘗試提供更即時的觀測視角,這功能為短期變動或臨時事件提供了參考依據。

順帶一提,Google Search Console 悄悄換了新 Logo。

檢索如何運作:不只是 bot 在爬而已(14:30~14:55)

這場技術分享讓大家意識到:「搜尋不只是 Googlebot 到處亂爬,背後邏輯超級縝密。」

完整流程包含:

- 底層協定:檢索牽涉到 TCP/IP、URL、DNS、HTTP Request 等基本網路知識

- Crawl Queue 排隊邏輯:會考量 sitemap、RSS、歷史資料與 GSC 提交項目,再依優先順序安排爬蟲行動

- robots.txt 強制規則:每次抓資料都會先檢查該頁面是否允許爬取

Googlebot 的來源也很廣,不只讀 sitemap,還包含你之前爬過的頁面、feeds、內部連結與外部連結。

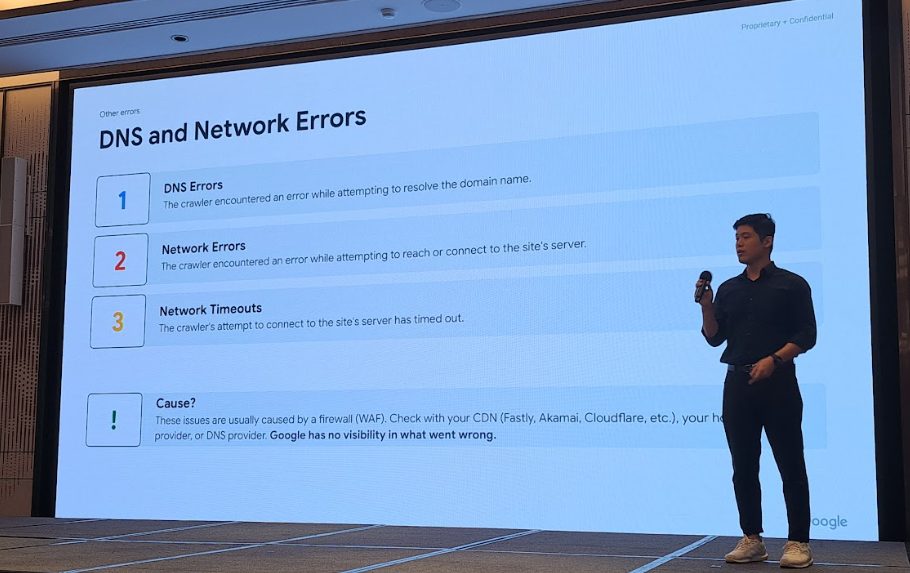

除了「該爬什麼」,現場也提醒大家要關心「檢索失敗怎麼辦」:

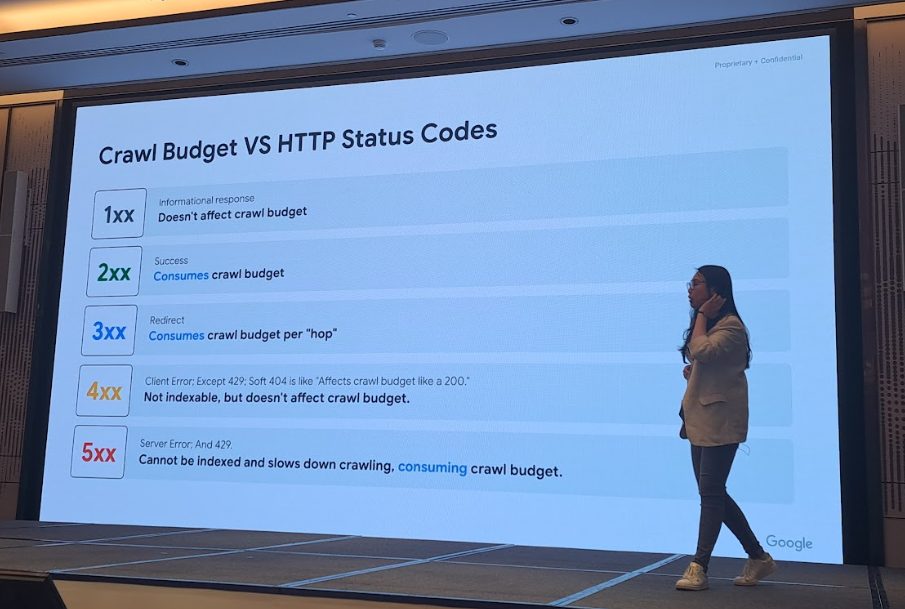

- Soft 404(回傳 200,但實際是無效頁):會被誤認為正常頁面,白白浪費檢索資源

- 3xx 跳轉:每一次轉址都會消耗爬蟲預算

- 5xx 伺服器錯誤:無法索引、拖慢爬蟲效率

- DNS 錯誤、Network Timeout:這些問題 GSC 看不到,要靠 CDN(如 Cloudflare)或 DNS 供應商協助排查

一句話總結:搜尋系統很挑剔,別讓錯誤頁面浪費你寶貴的曝光機會。

延伸閱讀:HTTP 狀態碼、網路和 DNS 錯誤,以及 Google 搜尋

Google 如何解讀 Robots.txt(15:25)

robots.txt:不是密碼鎖,是你網站的大門口

這場回顧了 robots.txt 的歷史:

「1994 年,只有 12 個網站使用 robots.txt,現在這東西幾乎無所不在。」

現場提醒幾個重點:

- robots.txt 是公開檔案,千萬不要放任何敏感資料

- 寫法要精準,特別是現在 AI 爬蟲也會來找你!

如果你不想讓 Bard 或 Vertex AI 檢索你的網站,可以這樣寫:

user-agent: google-extended

Disallow: /

延伸閱讀:Google 如何解讀 robots.txt 規格

Google 如何看待檢索預算(15:55)

這段講解了大家最常聽不懂、但其實關係很大的「Crawl Budget(檢索預算)」:

「簡單來說,就是 Googlebot 一次願意爬多少頁。」

它取決於:

- 網站整體品質

- 網頁的變動頻率

- 伺服器反應速度

以下幾種情況會嚴重消耗預算:

- ❌ 無限動態 URL(篩選器、排序參數)

- ❌ 重複內容、無效頁

- ❌ 錯誤狀態碼(尤其是 5xx、Soft 404)

小網站通常不用太擔心,但中大型網站、媒體、電商平台一定要留意!GSC + log 監測會是你最佳拍檔。

有人問:「AI Mode 會讓網站被爬更多嗎?」

Gary 給的答案是:有可能。AI 搜尋需要更多上下文與延伸資料,Googlebot 的出動次數可能會微幅上升。

⚡Lightning Session B:大規模網站的檢索管理實戰(16:15)

這場以大型網站經營為主題的閃電講,講者們分享了三個真實案例:

1️⃣ 案例一:100M+ 頁面的大型網站怎麼優化?

- 無價值 tag 頁一律設為 noindex

- API 類頁面透過 robots.txt 阻擋

- 降低不重要頁面的內部連結密度,避免分散爬蟲資源

講者連結:Gaston Riera – SEO Specialist

2️⃣ 案例二:印度航空靠自動內連拯救搜尋成效

印度航空透過 6 種頁面模板 × 16 個主要營收國家,一口氣產出了 107,000 個頁面,野心不小。但結果卻不如預期,雖然量做出來了,非品牌關鍵字的搜尋流量卻接近 0,這些新頁幾乎沒有被好好索引或取得良好排名。

團隊深入分析後發現,問題關鍵不在內容,而是結構:「缺乏內連、沒有主題性連結關係,讓 Googlebot 根本不知道它們有價值。」

- 解法:加入「附近城市」的相關頁面互連、根據季節推出「季節航線」連結

- 成果:工作階段增加 846%、孤兒頁減少 97%

講者連結:Lakshey Bahl

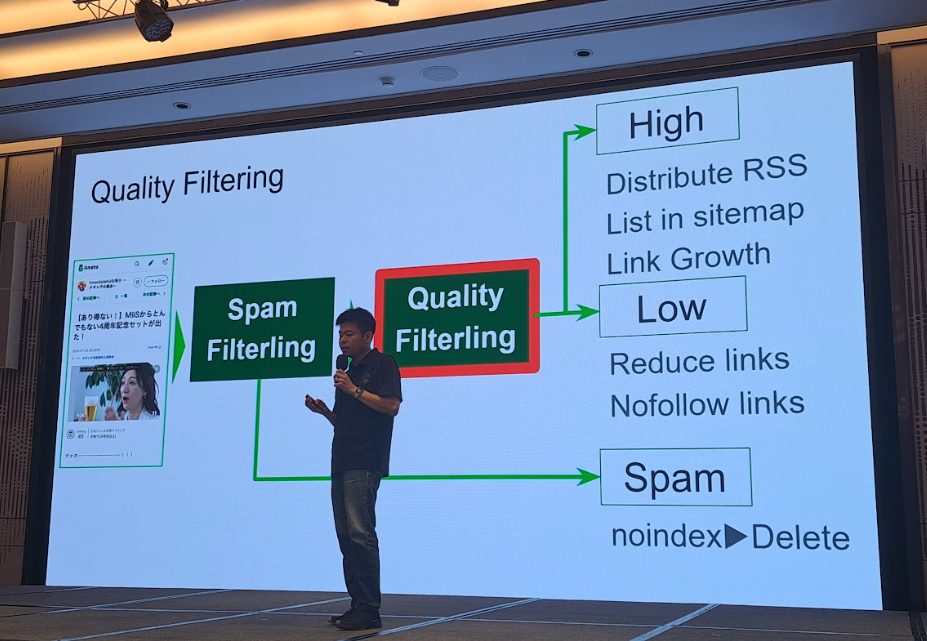

3️⃣ 案例三:內容品質過濾實戰(Satoshi Kimura)

Satoshi Kimura 的分享則更偏向「內容風險控管」視角,他的網站充斥大量低品質內容,包括:

- Affiliate Spam(純聯盟行銷導向頁)

- Doorway Pages(為特定關鍵字塞出來的虛頁)

- 外部連結堆疊 Spam(只為導流、沒內容價值)

這些內容不只無助於搜尋表現,還會拖累整體索引效率。

Kimura 團隊做了一套「ML Quality Filtering」流程,整合 GSC 與內部網頁報表數據,分成三層過濾:

- Spam Filtering:直接判斷是否為違規內容,noindex 或刪除

- Quality Filtering:用機器學習模型判斷是否為高品質內容

- 分類後處理:高品質的內容會被送進 sitemap、設定內連、加入 RSS;低品質內容就不讓 Googlebot 浪費資源了

過濾指標包含:文字數量(Word count)、圖片數量(Image count)、關鍵字分布(TF-IDF 分析)

- 解法:建置上述 ML Quality Filter,整合 TF-IDF、文字長度、圖片數等指標

- 成果:高品質頁面索引率提高到 96%,整體流量成長 30%

講者連結:Satoshi Kimura

❓QA時間問答精華

經過一天滿滿的技術與策略乾貨,最後的 Q&A 時間一樣精彩,下面幫大家整理幾個最值得記住的提問與回應

Q1|GSC 會提供 AIO 搜尋的曝光數據嗎?會與傳統搜尋區隔嗎?

A:目前沒辦法,因為技術架構不同。

主持人最後拋下一句:「Maybe…」現場氣氛大家不太滿意。

Q2|你們說 AIO 滿意度高,那怎麼測的?數據在哪?

A:我們有驗證過!只是不方便現場 AirDrop 給大家(開玩笑)。

Q3|llms.txt 有助於 Gemini 收錄或排序嗎?

A:不建議使用,也沒有必要。

Google 認為:沒理由特地告訴 AI「你可以讀這個網站」,因為 AI 是用來理解、不是用來遵守限制的機器(跟 Googlebot 邏輯不同)。

Q4|AI 搜尋減少點擊,SEO 還重要嗎?怎麼衡量參與度?

A:重要!只是衡量方式變了。

現在看的是「品牌有沒有出現在多個版位」圖片、影片、知識卡等,而不只是傳統點擊數或排名。前面的閃電講 Presence > Position 的觀念再次被強調。

Q5|已經提交 sitemap,為什麼還會被回報 URL 沒有參照 sitemap?

A:因為 Googlebot 可能早就在別處看到你的網址了。

所以不用太擔心,這不是錯誤,只是抓取來源不同。

Q6|為什麼不分辨 AI 寫還是人寫?Google 不在意嗎?

A:我們有試著分辨,但實在沒意義。

不像圖片可以從畫風判斷,文字太難分了。Google 更在意的是「品質好不好」而不是「誰寫的」。

Q7|2xx 狀態碼比例要到 90% 才算健康嗎?

A:沒有這種標準比例。

Q8|robots.txt 可以直接用中文路徑阻擋嗎?會不會出現編碼問題?

A:沒問題,直接用中文網址就可以。

Q9|明明狀態碼是 200,為什麼 GSC 還說有檢索或索引問題?

A:可能是報表資料延遲造成的差異,建議對照時間戳記來看。

Q10|Google 未來會針對 AI 檢索/抓取內容出指令嗎?

A:有討論中,未來 robots.txt 可能會新增 AI 專用語法。

Q11|AI Mode 什麼時候正式推出?

A:講了會沒工作(Gary 原話 XD)

awoo 的觀察與反思

從今天的議程可以看出,AI 搜尋並非取代 SEO,而是逼著我們回到本質:內容品質、技術基礎與結構策略才是關鍵。

不管是 Gary 提到的「不用做 GEO,只要把 SEO 做好」,還是講者強調的 Presence 觀念與 Product-led SEO 實例,都讓我們更確信:

搜尋引擎變了,做 SEO 的方法也要跟著進化,但原則沒有變!有價值的內容 + 正確的技術邏輯,才是長久之道。

結語

Search Central Live Deep Dive 為期三天,不只是資訊密集的研討會,更是與全球搜尋專家交流的平台。awoo 將持續追蹤相關趨勢與實務應用,協助品牌掌握搜尋優化機會。

如有任何網站流量成長相關問題與需求、或想瞭解更多 awoo SEO/SEM 服務,歡迎立即諮詢,將有 awoo 專業顧問與您聯繫。

下一篇是活動第二天,主題將聚焦在「索引邏輯進階解析 × 非文字內容收錄 × 電商與國際化 SEO 實作」,敬請期待!

如有任何網站流量成長相關問題與需求、或想瞭解更多 AI SEO/GEO 服務歡迎填寫表單立即諮詢,將有 awoo 專業顧問與您聯繫。

Contact Us

「*」代表必填欄位